鴻蒙4里的大模型,能否撐起華為的野心?

這幾天,關于鴻蒙4的文章、報道,可謂沸沸揚揚。

一時間,就算是不關注AI賽道的人,都聽說了這個新系統里有個大模型,它大致相當于被升級、強化后的Siri。

比如能幫你生成點文章摘要、圖片,或是自動訂個酒店什么的。但是,華為的野心,可不止是在手機里干點生成圖片、文字的小花活。

人家可是把萬物互聯的夢想,都寄托在了這個小小的AI之上了呢。

具體來說,就是以手機上的大模型為起點,不斷將智能化技術擴散到智能家居、智能汽車、甚至是智能城市之上。

如此,最后就能形成一個“萬物互聯”的超級終端。

其實,這不只是華為的野心,蘋果、高通、榮耀等大廠都進行了類似的布局。

畢竟,大模型與終端的結合,是下一階段AI戰場必爭的陣地。

然而,要知道,現在有點競爭力的通用大模型,體量和參數,往往都是一千億規模往上的。

要想把這么一坨“龐然大物”塞進小小的手機,還要能保證性能,絕非易事。

如果關鍵的技術問題沒處理好,大模型終端化的夢想,最終將難免會淪為鏡花水月。

1

可靠性問題

要讓大模型進入終端,首先要解決的問題之一,就是輸出的可靠性問題。

畢竟,任何使用過大模型的人,幾乎都見識過各種各樣的幻覺和謬誤,而這樣的幻覺一旦出現在終端側,產生的損失和后果,往往比處理“案頭工作”時要嚴重得多。

例如,在鴻蒙4的發布會上,華為就介紹到:大模型AI小藝,會根據你的地點數據等信息為你個性化推薦信息。以出國旅行為例,在出發前小藝會提醒你出行信息,出發后小藝會給你推薦翻譯等實用功能,到目的地后,則會展示當地的美食和地點導航。

然而,倘若處理不好可信、可控問題,一個可能出現的情況是:由于信息過時或錯誤,小藝告訴了你一個已經變遷或不存在的地點。不知情的你被“帶偏”后,才恍然自己走了不少冤枉路。

同樣地,在智能駕駛領域,倘若車輛上的大模型在終端側輸出不可靠,就會導致規劃決策結果出現不合理、不符合交通規則的情況,影響車輛的行駛效率和安全性。

類似的情況,如果出現在2B端,只要存在1%的偏差,都將給企業埋下風險的種子,成為落地的門檻。

目前,關于大模型可信、可控方面的問題,學術界沒有完美解,只能在各個環節逐步逼近。

但有一點卻是業內的共識,那就是:預訓練數據越多、越廣,就越可以提高大模型的泛化能力和魯棒性,從而減少生成幻覺和錯誤的可能性。

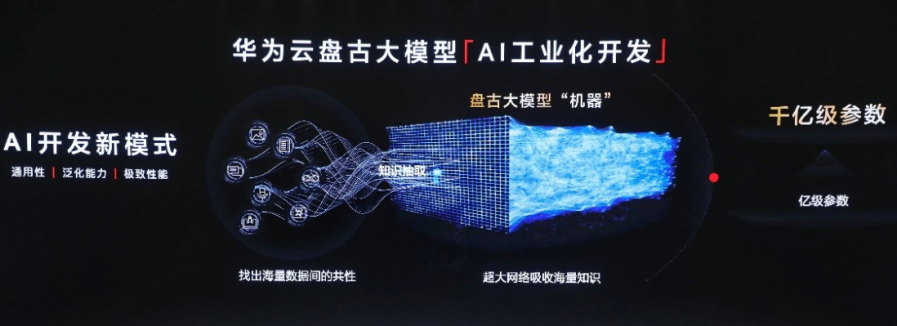

在之前披露的信息中,華為對外宣稱自身的盤古大模型涉及項目超過1000個,除了學習大量通用知識外,盤古還深耕金融、政務、氣象、醫療、健康、互聯網、教育等行業,每個行業數據量超過500億tokens。

從數據層面來看,可謂涵蓋面甚廣。

但需要注意的是,盤古大模型實際上分為了四個版本,分別是100億參數、380億參數、710億參數和1000億參數。考慮到手機的硬件性能和運行環境,鴻蒙4中搭載的,很有可能是100億參數版本的盤古大模型。

想在這100億的數據規模上,保障大模型的準確性、可靠性,可能嗎?

對于這個問題,華為有兩種可能的解決方案:

首先一種,是直接將鴻蒙4中的大模型,變成一個看似通用的“專用”大模型。

這樣的思路,其實是一種小而精的策略。

因為在某些特定場景,預訓練數據的質量和相關性,遠比其數量和范圍要重要得多。

具體到手機方面,由于人們使用手機的場景、用途,都是相對比較固定的,例如查天氣、導航、訂外賣、訂酒店等,因此華為可以根據這些特定的“手機場景”,針對性地搜集相應的高質量數據。

而經由這種高質量、高相關性數據訓練出來的緊湊型語言模型,有可能在特定任務和場景上表現得比大參數模型更出色。

而第二種方式,則是通過“壓縮”的方式,在不犧牲性能和精度的情況下,降低模型的參數。

2

化大為小

可以說,壓縮功力的強弱,直接關系到了端側大模型的可靠性、質量。也是大模型走向端側的必要條件。

因為只有把模型壓縮到了完全能在終端側運行,擺脫云端計算的地步,大模型才能適應更多對延遲性要求高的邊緣場景。

例如,智能汽車對于模型運行的可靠性和延遲要就非常高,在實時變化的路況中,如果在云端運行大模型,并且使用網絡把結果傳送到終端,肯定無法滿足智能汽車的需求。同時,完全終端化、本地化的運行方式,也是出于對用戶數據、隱私方面的一種考慮。

這也是為什么,頗為重視隱私的蘋果,也宣布自己將要發布的AppleGPT將采取完全本地化的方式運行。

同樣地,在鴻蒙4上,華為表示AI“小藝”相關的數據和學習的都是在端側推理,以保障用戶的安全和隱私。

既然“壓縮”是大模型終端化的必要條件,那么目前在這方面,華為和其他大廠的差距究竟如何呢?

在之前的WAIC大會上,高通展示的手機大模型,已經能做到在安卓手機上,直接運行參數規模超過10億的StableDiffusion,而且生成效果也還過得去。

而這背后,靠的正是不俗的模型壓縮能力。

通過量化、壓縮、條件計算、神經網絡架構搜索和編譯,高通在不犧牲太多精度的前提下對AI模型進行了縮減。

比如在在量化方面,高通將FP32模型量化壓縮到INT4模型,實現了64倍內存和計算能效提升。

在這方面,華為自身的昇騰模型壓縮工具,也提供了一系列的模型壓縮方法,根據量化方法不同,分為基于calibration的量化和基于retrain的量化。

而上述兩種量化方法,根據量化對象不同,分為權重量化和數據量化。而具體來說,權重量化對模型影響不大,而數據量化對模型影響比較大。

這樣的影響,可以用一個形象的比喻來說明:

壓縮大模型就像切西瓜,而權重量化就像是把西瓜的種子變成整數,數據量化就像是把西瓜的果肉和果汁變成整數。

一般人吃西瓜的時候,更在乎的往往是果肉,而不是種子。

同理,權重是模型的一部分,但不是最重要的部分,我們運行模型的時候,主要關注的是輸入輸出數據的準確性和多少。

也正因如此,在用戶可感知到的范圍內,權重量化對模型性能的影響是較小的。而具體來說,權重量化對模型影響不大,而數據量化對模型影響比較大。

這樣的影響,可以用一個形象的比喻來說明:

壓縮大模型就像切西瓜,而權重量化就像是把西瓜的種子變成整數,數據量化就像是把西瓜的果肉和果汁變成整數。

一般人吃西瓜的時候,更在乎的往往是果肉,而不是種子。

同理,權重是模型的一部分,但不是最重要的部分,我們運行模型的時候,主要關注的是輸入輸出數據的準確性和多少。

也正因如此,在用戶可感知到的范圍內,權重量化對模型性能的影響是較小的。

例如,音箱中的智能助理,可以幫助我們管理智能家居;在工作場合,耳機中的智能助理可以作為秘書幫助處理會議紀要等工作。

在這種情況下,誰若能率先取得多模態方向上的突破,針對不同場景微調,提供多樣化、專屬化的智能助理,誰就能在終端大模型的長跑中,處于領先優勢。

此外,考慮到手機、智能家居等終端設備,具有很強的“私有性”,因此,如何根據用戶的個人喜好和使用習慣,進行自適應學習,并提供個性化的建議和服務,就成了終端大模型能否長期陪伴用戶的關鍵因素。而倘若上述問題,都得到了較好的解決,那么一個以大模型作為終極操作系統(AIOS)的AI時代,就遲早會到來。

到了那時,分散、割裂、碎片化的物聯網應用市場,也終將被大模型AIOS統合。